Da mesi ormai sono molteplici le polemiche che infuriano contro le AI e le società che le sviluppano. Molti si preoccupano del loro possibile utilizzo per creare deepfakes sempre più convincenti a partire dalle foto presenti online, altri per il pericolo di vedere riprodotta la loro immagine anche in situazioni in cui non sono presenti e senza la loro autorizzazione, altri ancora, soprattutto artisti e content creator, sono molto preoccupati della possibilità che le intelligenze artificiali possano produrre contenuti usando le loro opere, violando così le norme a tutela della proprietà intellettuale.

Tuttavia recentemente alcuni ricercatori dell’Università di Chicago hanno inventato una possibile soluzione per alcuni di questi problemi: si tratta di Nightshade, un nuovo software capace di avvelenare le intelligenze artificiali e portarle a produrre un contenuto molto differente da quello di partenza, impedendo così che le varie opere protette da copyright siano indebitamente riprodotte.

Ma come funziona questo nuovo programma e come fa a ingannare le AI? Ecco alcune informazioni sul suo funzionamento di base.

Nightshade, il software capace di avvelenare le AI

Di base, come decretato dagli USA alcuni mesi fa, è difficile considerare quanto fatto dalle intelligenze artificiali una vera e propri violazione del copyright. Le AI infatti, quando vengono create, devono innanzitutto attraversare una fase chiamata addestramento, durante la quale l’intelligenza artificiale viene fornita di una serie di informazioni e input che le insegnano sostanzialmente a fare quello per cui è stata creata, come mostrato, ad esempio, dal famoso caso dell’AI progettata per giocare a Pokémon Rosso.

Solo dopo questa fase di apprendimento, l’intelligenza artificiale è pronta per produrre nuovi contenuti, testi, immagini o suoni. Tuttavia nessuno di questi è, almeno teoricamente, l’esatta riproduzione di un contenuto coperto da copyright, perché risultato dalla rielaborazione da parte di un’intelligenza che ha combinato diversi contenuti tra loro, un po’ come avverrebbe per un qualsiasi autore umano.

Di conseguenza, per difendere i propri contenuti dagli assalti delle AI, agire per vie legali non è poi così efficace e forse la soluzione migliore è provare a bloccare il problema prima ancora che il nuovo contenuto venga generato. Per questo è stato creato Nightshade, un programma capace di introdurre all’interno delle opere elementi che ingannano le AI e le inducono a riprodurre qualcosa di molto diverso dal contenuto originale.

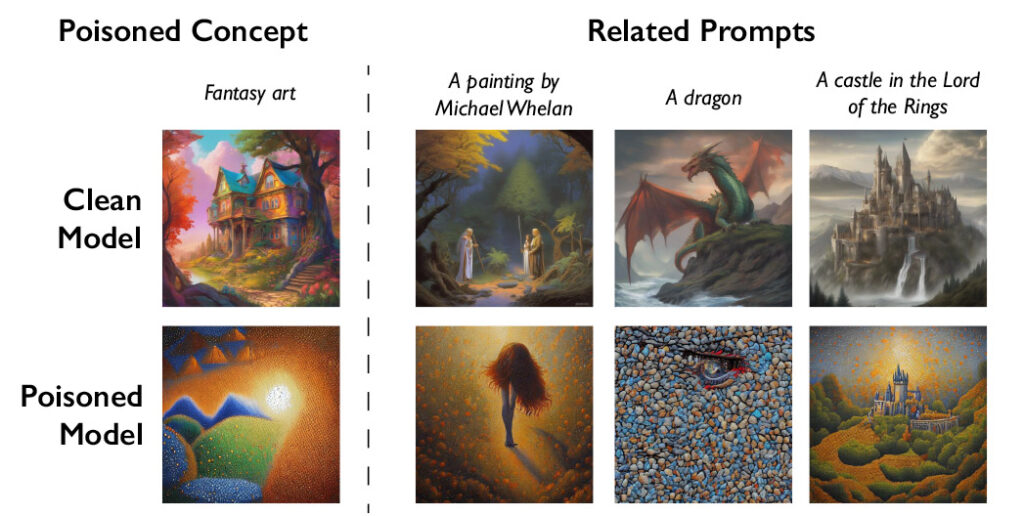

In particolare, il software agisce sulle immagini alterando i pixel che le compongono in maniera impercettibile all’occhio umano. Per gli umani dunque la differenza fra le due non esiste. Le AI invece, se utilizzeranno la fonte inquinata durante la fase di apprendimento, non potranno fare altro che interpretarla male e riprodurre successivamente qualcosa di differente dall’originale. Ad esempio, è possibile modificare un’immagine raffigurante dei cani in maniera tale che l’AI veda invece, al loro posto, dei gatti, come mostra la seguente immagine. Infatti, maggiore sarà il numero dei pixel modificati, maggiore sarà la differenza all’interno dell’immagine generata artificialmente.

Questa tecnica di avvelenamento è, al momento, molto difficile da individuare e contrastare per i costruttori di intelligenze artificiali, come mostrato dal documento ufficiale relativo allo studio. Per difendersi da Nightshade, sarebbe infatti necessario trovare e rimuovere durante la fase di addestramento tutte le immagini modificate. Tuttavia, visto che le immagini sono spesso inserite in ampi set di addestramento, il lavoro di rimozione sarebbe di certo molti difficile e laborioso.

Nightshade potrebbe dunque rappresentare, almeno per ora, il principale strumento di difesa per tutti coloro che vogliono proteggere i propri contenuti dalle intelligenze artificiali. Sarà dunque interessante vedere quanto sarà utilizzato in futuro e se verranno o meno creati altri metodi per contrastare le AI.