ChatGPT e ciò che l’ha resa possibile, ovvero OpenAI, sono ormai due nomi piuttosto familiari sul web. La chat governata dall’intelligenza artificiale più potente dell’internet ha stupito centinaia di migliaia di persone in tutto il mondo con ciò che è in grado di fare, e la stessa cosa è accaduta anche per i software generatori d’immagini prodotti sempre da OpenAI.

Il creatore di ChatGPT è al momento occupato con le trattative di un potenziale investimento da 10 miliardi di dollari da parte di Microsoft, a indicare l’enorme successo della sua idea. Ma come ogni grande progetto di grande successo, ci sono alcuni aspetti “oscuri” che hanno contribuito all’ascesa, e che vengono fuori quando la questione si fa fin troppo grande.

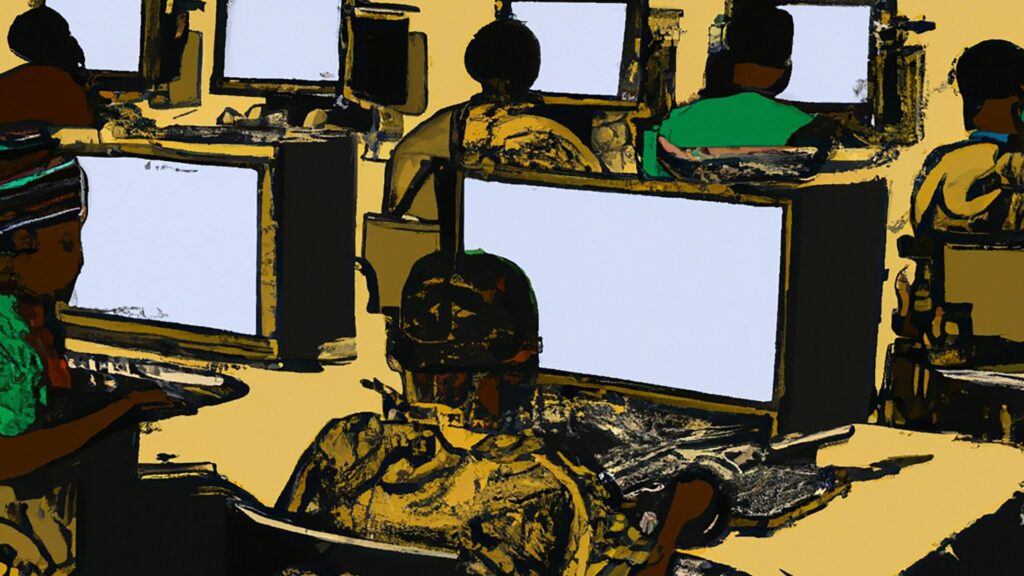

In questo caso, pare che per addestrare ChatGPT a essere meno volgare, razzista e violenta, siano state utilizzati lavoratori appositi con il compito d’individuare le frasi tossiche e offensive. Solo gli esseri umani, infatti, sono in grado di utilizzare la morale e di filtrare in questa chiave le informazioni raccolte dall’intelligenza artificiale. La stessa azienda che voleva rimuovere i contenuti offensivi, però, avrebbe sottoposto migliaia di lavoratori a condizioni inadeguate e con pessime conseguenze sulla loro psiche.

La testimonianza dell’azienda incaricata da OpenAI

La società che era stata incaricata di questo lavoro è Sama, un’azienda con sede a San Francisco e una filiale in Kenya. A tale società sono stati inviati estratti di migliaia di testi a fronte di un contratto da 200 mila dollari, che avrebbe retribuito i dipendenti che si sarebbero occupati dell’ascolto e della visione dei contenuti. Peccato che in realtà pare che ai dipendenti sia stata destinato molto meno di quanto pattuito.

Molti dipendenti si sono ritrovati dunque ad essere pagati da 1,32 a 2 dollari l’ora per revisionare una grandissima mole di contenuti di ogni tipo (dai 150/200 brani che andavano dalle 100 alle 1000 parole), dal più al meno scabroso e dovendo sopportare condizioni di lavoro dunque piuttosto difficili. Però, secondo quanto dice OpenAI, tutto ciò era l’unico modo per classificare e filtrare i contenuti dannosi.

Il prezzo da pagare per rendere possibile ChatGPT, è stato dunque far lavorare decine e decine di persone con condizioni ben al di sotto degli standard ragionevoli ed esponendoli a contenuti disturbanti. Da torture, a rapporti non consenzienti: in alcuni casi, dei dipendenti hanno dichiarato di aver avuto gli incubi durante la notte.

Tant’è che nel 2022 Sama ha rinunciato al suo contratto, divenuto ormai insostenibile e OpenAI aveva chiesto all’azienda anche di raccogliere immagini classificate come illegali, cosa che non compariva nell’accordo iniziale e che avrebbe rischiato di mettere l’azienda nei guai con le autorità. OpenAI, ad oggi, nega che questa richiesta ci sia mai stata.

L’inchiesta del Times, che ha fatto emergere tutte queste informazioni, è ancora più dettagliata e descrive sia gli stipendi (con annessi “benefit” per i contenuti più tremendi) che alcuni dei contenuti disturbanti che gli operatori si sono trovati a dover leggere e considerarne attentamente l’idoneità.