Il volto è il nostro “biglietto da visita”, un elemento fondamentale che spesso influenza l’impressione che diamo e come veniamo trattati dalle altre persone. Quante volte avrete sentito l’espressione “brutto ceffo”, usata per indicare una persona poco raccomandabile? Ebbene “ceffo” vuol dire proprio “faccia”.

Oltretutto il viso, grazie alla sua conformazione unica, rappresenta un ottimo mezzo di identificazione dell’individuo. È questa la ragione per cui, quando una persona vuole celare la propria identità, è solita nascondere il volto.

Con l’evoluzione delle tecnologie, oggi è possibile far generare a una Intelligenza Artificiale (IA) dei volti fittizi che sembrano appartenere a persone realmente esistenti. A sostegno di questa tesi c’è un recente studio, pubblicato sul PNAS (Proceedings of the National Academy of Sciences) e realizzato da Sophie J. Nightingale e Hany Farid.

L’IA analizzata

Prima di esporre la ricerca e i suoi risultati, è necessario comprendere il tipo di IA preso in considerazione: la GAN. La Generative Adversarial Network è una delle tecnologie più usate per la sintesi di materiale audio e video, e di conseguenza dei deep fake, ossia dei contenuti video in cui vengono sovrapposte sapientemente 2 o più immagini.

Le GANs operano mediante 2 circuiti logici diversi e contrapposti, vale a dire il generatore e il discriminatore. Nel caso in analisi, il generatore crea il volto di una persona fittizia partendo da un insieme casuale di pixel, il discriminatore invece compara gli elementi della faccia “artificiale” con altri appartenenti però a persone reali. Se il circuito individua delle differenze, penalizza il generatore.

Grazie alle numerose interazioni tra i circuiti logici, l’Intelligenza Artificiale “impara” a sintetizzare dei volti fittizi sempre più realistici fino al punto in cui il discriminatore non riesce più a distinguerli da quelli reali.

La fase preliminare alla sperimentazione

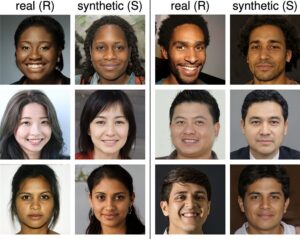

Per effettuare la ricerca, gli studiosi hanno realizzato un paniere di 800 volti, composto da 400 facce reali e da 400 facce sintetizzate da StyleGAN2. Per quanto riguarda i volti sintetizzati, questi sono stati scelti secondo i principi della parità di genere (200 maschili e 200 femminili) e di razza (100 caucasici, 100 neri, 100 asiatici e 100 medio orientali). Sono state scartate tutte le immagini palesemente false.

Per ogni volto fittizio, poi, è stata scelta la foto di una faccia reale corrispondente per sesso, razza, età e aspetto fisico.

Gli esperimenti effettuati

Compreso il funzionamento dell’Intelligenza Artificiale e il pool di analisi, è necessario capire se i volti sintetizzati siano idonei a ingannare un essere umano. A tal fine, i ricercatori hanno architettato ben 3 tipi di test.

L’esperimento numero 1

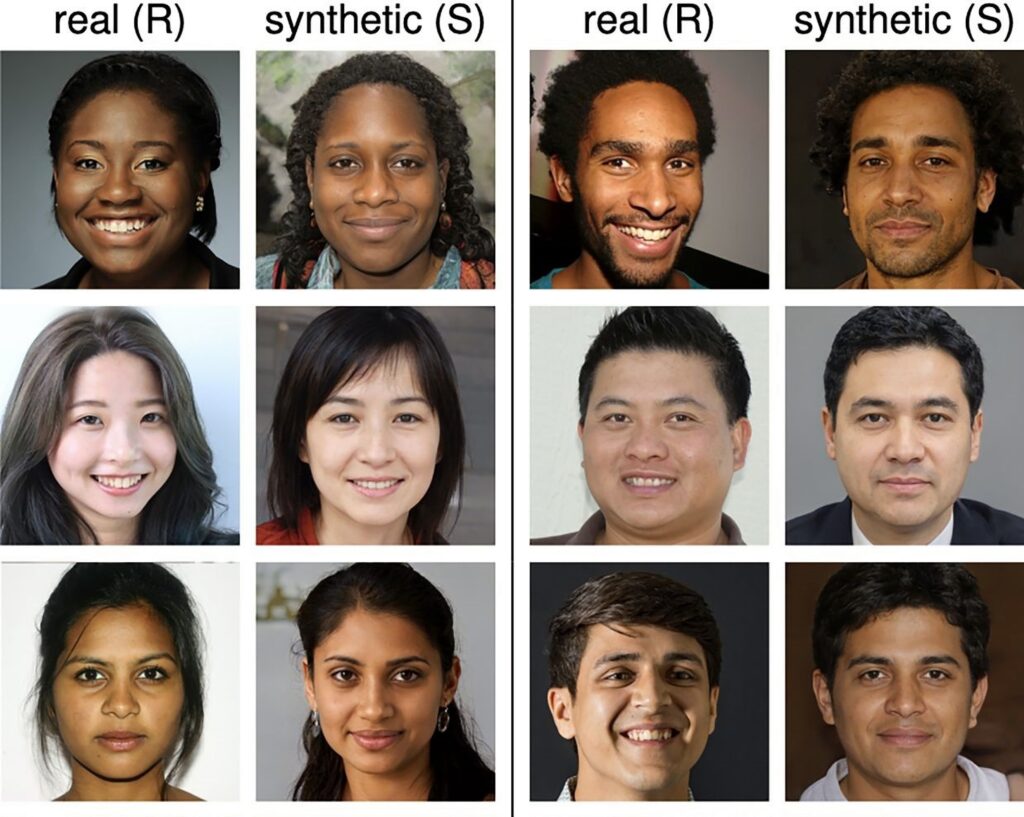

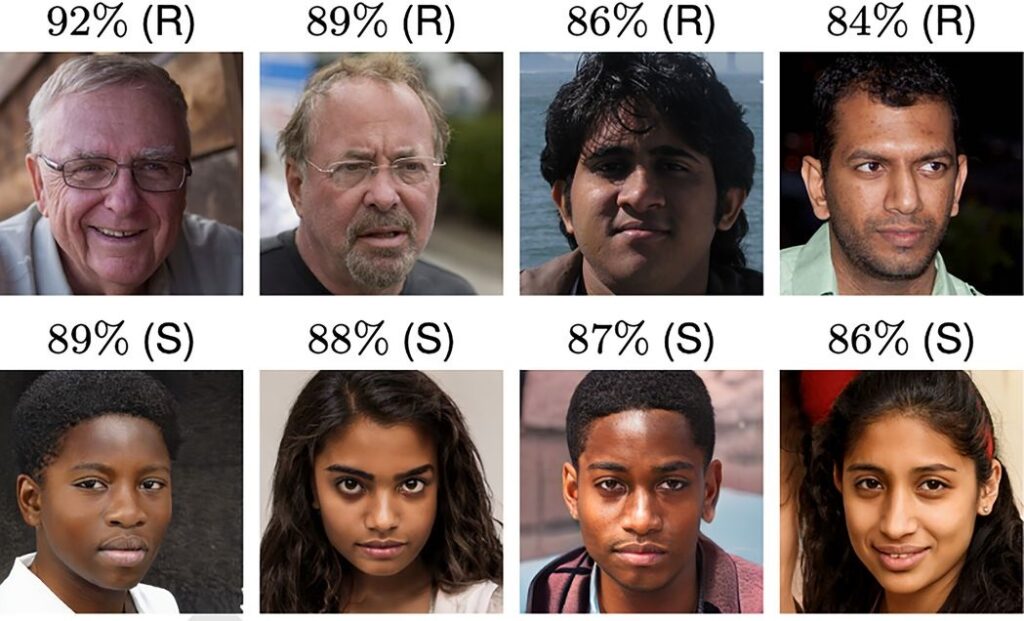

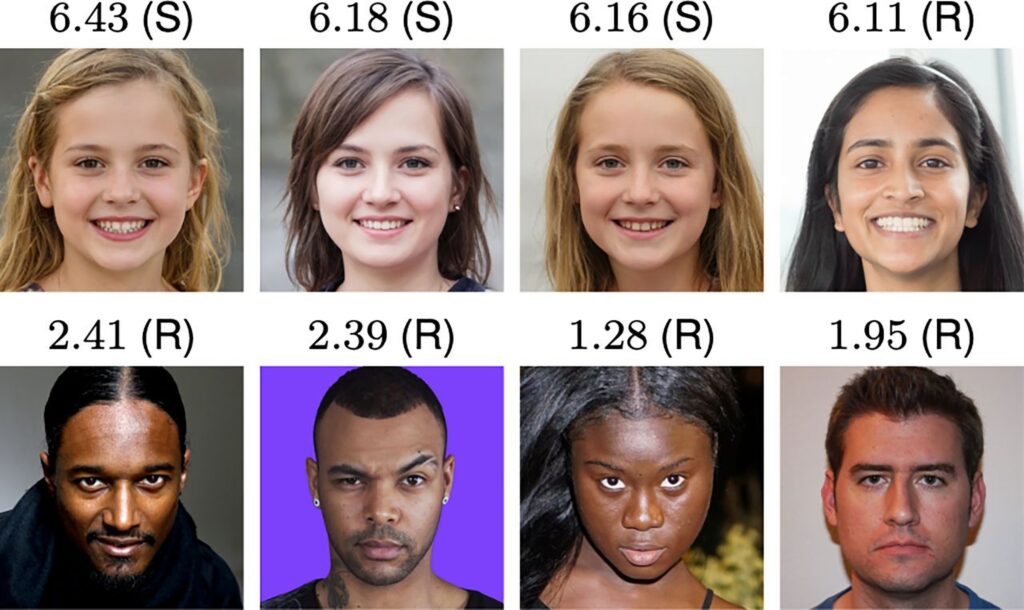

Nella prima sperimentazione a 315 partecipanti sono state mostrate, una alla volta, 128 immagini. I soggetti devono distinguere le facce appartenenti a persone reali da quelle sintetizzate. La percentuale di successo generale è stata del 48,2%. Sui dati raccolti sono state effettuate ulteriori analisi al fine di comprendere gli effetti che la razza o il sesso del volto mostrato hanno sulla percentuale di successo.

Il risultato è degno di nota: per quanto riguarda i volti reali, la probabilità di successo è più alta nei maschi asiatici rispetto alle femmine asiatiche e nei maschi caucasici rispetto alle femmine caucasiche. Per le facce sintetizzate, invece, i volti di persone caucasiche presentano la più scarsa percentuale di successo rispetto a tutte le altre razze (qui i ricercatori ipotizzano che ciò sia dovuto a una iper-rappresentazione della razza caucasica, che ha portato a un migliore “addestramento” della macchina).

LEGGI ANCHE: Bruce Willis protagonista di una serie di spot russi, ma si tratta di un deepfake

L’esperimento numero 2

Nel secondo test, 219 nuovi soggetti sono stati chiamati a distinguere le stesse 128 facce mostrate in precedenza. La differenza con il primo esperimento consiste nel fatto che queste persone sono state allenate a riconoscere i volti reali da quelli fittizi, inoltre viene utilizzato il feedback trial by trial (in parole povere è comunicato subito se la decisione presa dall’individuo è corretta o meno).

Qui la percentuale di successo è salita al 59% (+10,8 punti percentuali). La tecnica del feedback non ha aumentato la possibilità di successo nel lungo periodo; infatti questa nelle prime 64 facce era in media il 59,3%, nelle ultime 64 58,8%.

Anche in questo caso sono state effettuate ulteriori analisi per capire se ci fosse un legame tra la razza e il sesso e la probabilità di successo. I risultati sono analoghi a quelli della prima sperimentazione.

L’esperimento numero 3

Nell’ultima ricerca, 223 partecipanti sono stati chiamati a valutare l’affidabilità di nuovi 128 volti. Il test ha l’obiettivo di comprendere se l’essere umano utilizzi gli stessi schemi mentali per giudicare un volto reale da uno fittizio. L’esperimento muove dalla tesi secondo cui a un uomo basti vedere una faccia per pochi secondi per creare un pregiudizio.

Nell’esperimento i soggetti attribuiscono una valutazione da 1 (poco affidabile) a 7 (molto affidabile) a tutti i volti che gli sono presentati.

Anche in questo caso emergono dei dati singolari: la media di affidabilità delle facce reali è pari a 4,48, leggermente più bassa di quella delle facce fittizie (4,82); oltre a ciò, i volti di razza nera sono stati giudicati mediamente più affidabili di quelli medio orientali, così come sono stai ritenuti più affidabili quelli femminili (4,94) rispetto a quelli maschili (4,36).

Le conclusioni

Dai dati raccolti nei test si possono trarre due importanti conclusioni.

La prima è che le immagini generate in modo più realistico appartengono a “persone” di razza caucasica, probabilmente perché l’IA è stata iper-esposta a quel tipo di facce. Ciò non di meno, anche i volti appartenenti alle altre razze presentano un altissimo livello di fotorealismo.

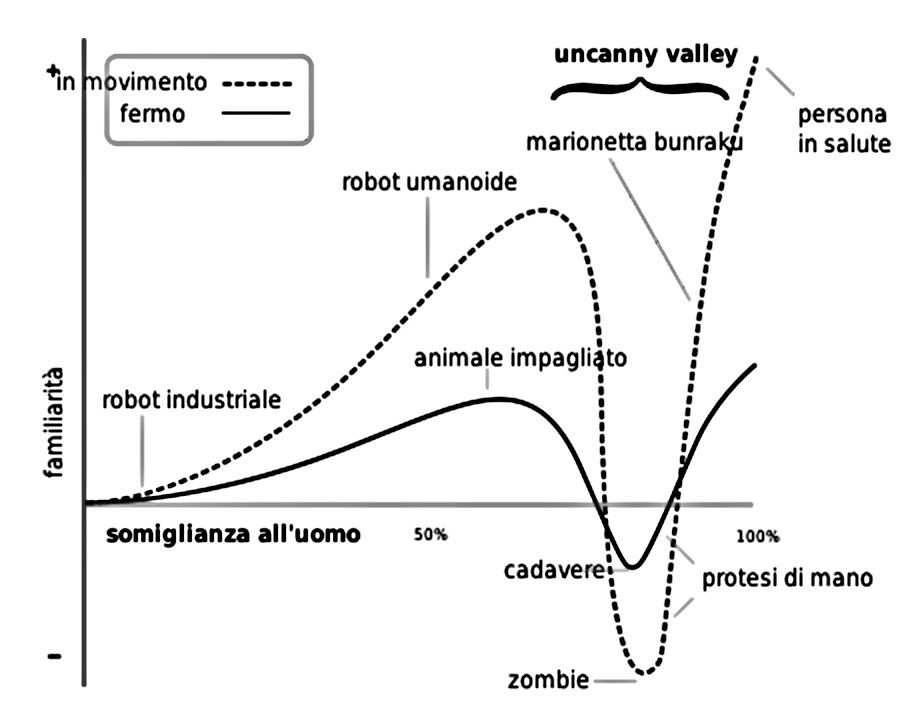

La seconda, invece, attiene all’affidabilità dei volti fittizi, che è più alta rispetto a quelli dei volti reali. Ciò è dovuto forse al fatto che le facce sintetizzate imitino quegli elementi dei visi reali considerati più affidabili. Per questo motivo, i volti prodotti dalla GAN sembrano superare l’uncanny valley, ossia la sensazione di repulsione e inquietudine provata dall’uomo alla vista di un robot o di un costrutto antropomorfo troppo realistico.

I risultati appena esposti, uniti al facile accesso da parte dell’utenza alle GANs, sono idonei a determinare l’aumento di condotte pericolose per la società e per il sistema democratico, come la creazione di profili falsi sui social media volti a perpetrare delle truffe o la creazione di deep fake molto realistici diretti a ledere l’altrui reputazione oppure ad attuare campagne di disinformazione su vasta scala.

Di conseguenza, a questo punto si delineano 3 politiche diverse: continuare a sviluppare questo tipo di tecnologia noncuranti delle conseguenze negative sulla società, arrestarla facendo così prevalere la sicurezza dei consociati sull’avanzamento tecnologico oppure permetterne l’avanzamento a patto di costruire un rigoroso sistema di salvaguardia della società. La scelta è ovviamente rimessa agli organi politici rappresentativi degli Stati.

A nostro avviso, la soluzione ideale sarebbe la terza; questa rappresenta una soluzione media tra l’esigenza dello Stato di salvaguardare la sicurezza e la tranquillità dei cittadini e l’interesse della scienza al progresso tecnologico.

Fonti: PNAS.org